Audio-Driven THG(二):V-Express与EchoMimic

前言

本文介绍V-Express与EchoMimic。

V-Express

在上一篇文章中我们介绍了阿里的Emote Portrait Alive,其非常惊艳的效果也催生了很多工作。

回顾一下,Emote Portrait Alive成功的模型上的因素是采用了双塔的reference net和denoising net结构,以及引入了较弱的控制信号。三个多月后的24年6月,第一篇使用该框架的开源工作出现了(不得不佩服大厂的速度~):V-Express[1]。

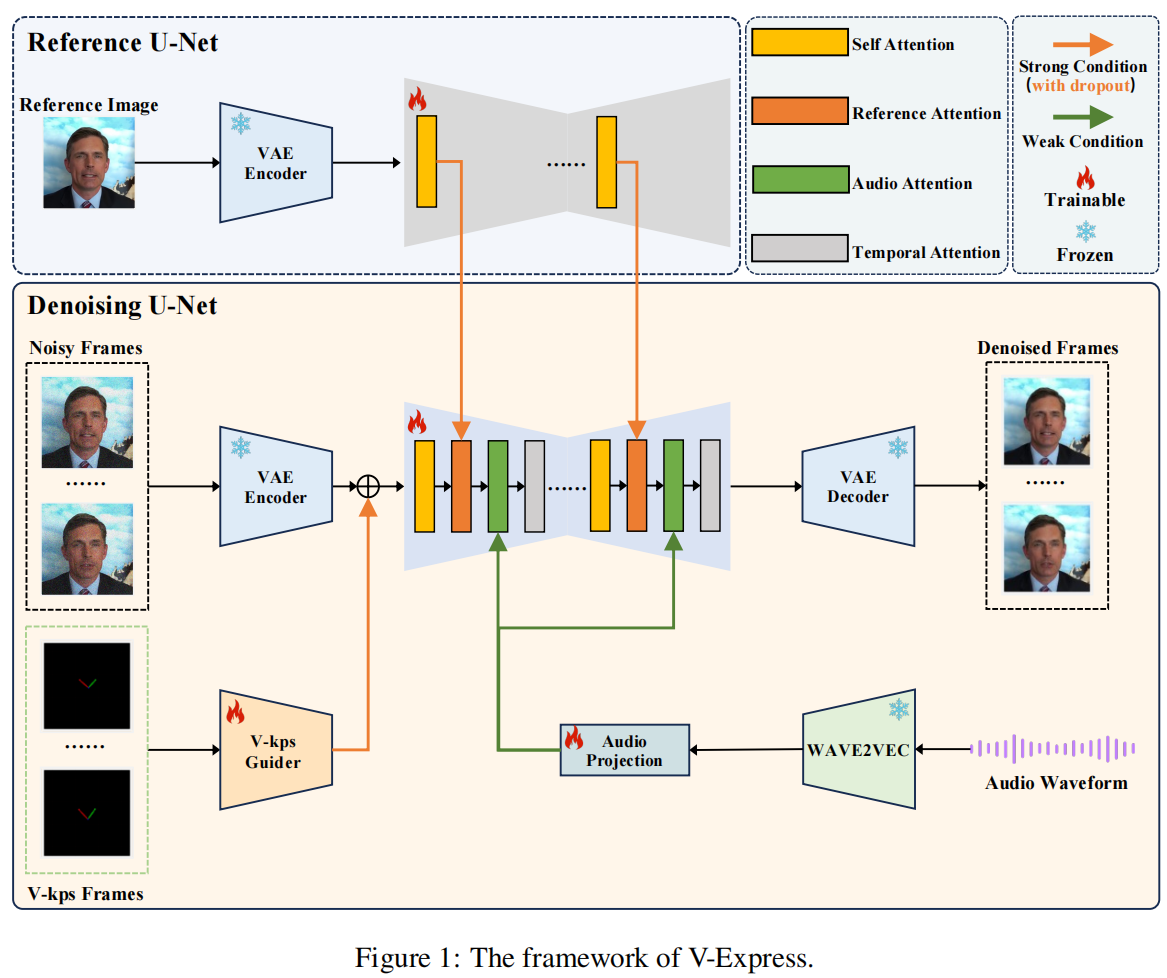

我们同样首先来看框架:

一样的配方,一样的味道,一样的self-attention,一样的reference net和reference attention,唯二的区别是audio和V-KPs。我们详细介绍一下。

V-Express的出发点是引入keypoints进行控制,然而作者发现这种控制太强,因此将其简化为了左眼中心-鼻子-右眼中心的“V”型结构控制,而后通过一个小卷积与噪音相加。同时为了不让V-KPs控制过强,对feature应用了50%的drop概率。此外音频也是用滑窗和cross-attention加入到denoising UNet中。

V-Express整体没有什么过多的新东西,贡献主要还是工程上的吧,是第一篇应用Emote Portrait Alive的工作,也是极为少见的在论文发表之前就开源代码的工作,让后续工作接近Emote Portrait Alive成为可能。

EchoMimic

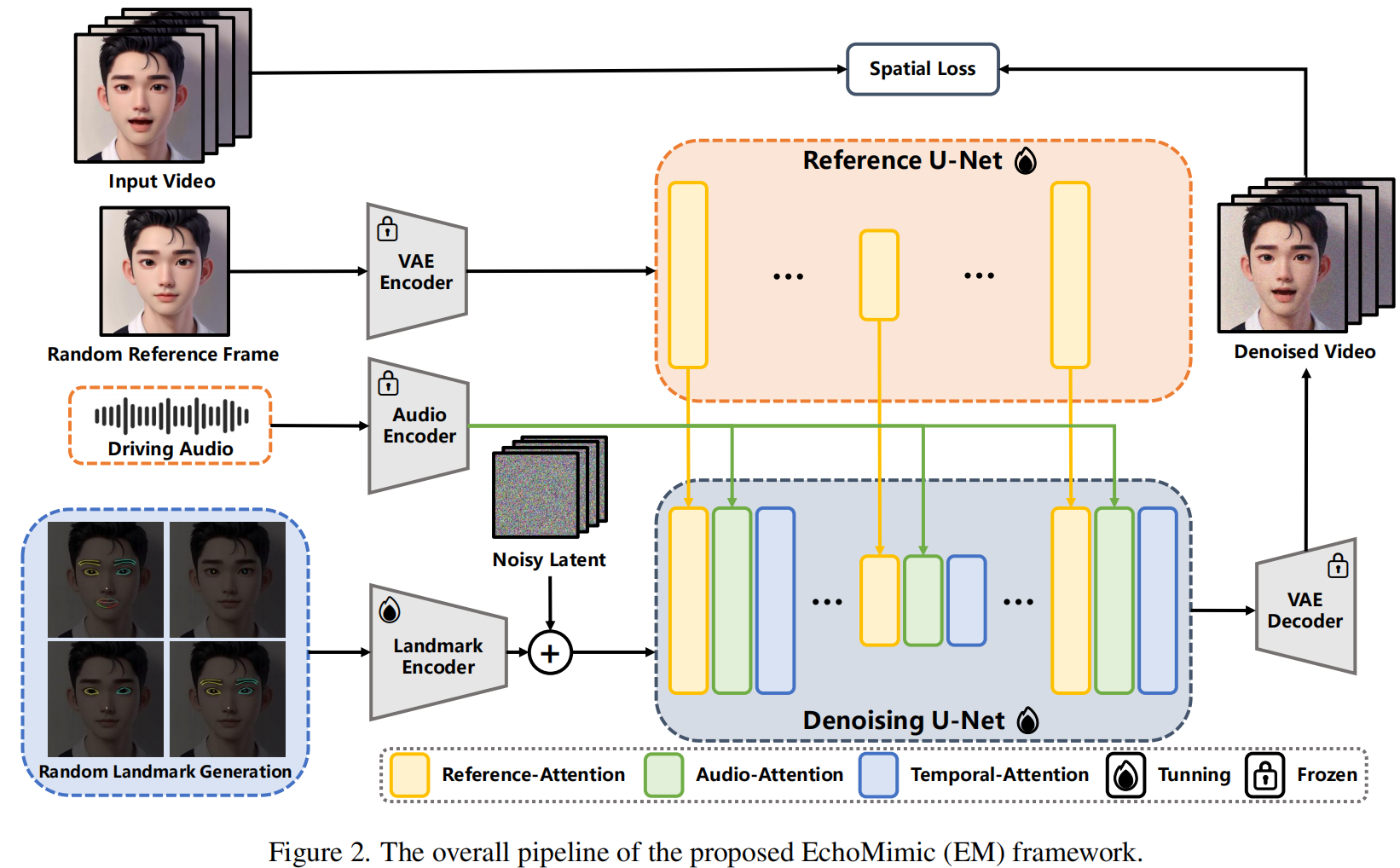

接下来我们介绍EchoMimic,其也希望用landmark控制,框架方面同样使用Emote Portrait Alive,只是去掉了denoising UNet中的self-attention,不过作者也没有提这一点,也没有相关的消融实验,暂且认为是效率方面的考虑吧。

在landmark方面,为了避免其控制过强,EchoMimic同样引入了随机drop,其将面部分为若干部分(如眉毛、眼睛、嘴部等),训练时随机drop掉一些部分的landmark。而后通过一个encoder与noise相加。

在训练loss上EchoMimic也有改进,之前的Emote Portrait Alive和V-Express都只用到了最基本的denoising loss:

$$ \mathcal L_{noise}=\mathbb E_{t,c,z_t,\epsilon}\|\epsilon-\epsilon_{\theta}(z_t,t,c) \|^2 $$

其中$t$是时间步,$c$是控制信号,$z_t$是$t$时刻下的latent noise,而$\epsilon$是加噪过程的noise。此外作者还额外加入了pixel的loss:

$$ \mathcal L_{pixel}=w(t)\Big[L_2(I_p,I_{GT})+LPIPS(I_p,I_{GT}) \Big] $$

其中$I_p,I_{GT}$分别是将latents用VAE映射回pixel空间的图片,$w(t)=\cos(t\times \frac{\pi}{2T})$是为了降低大时间步的权重,可能是发现时间步太大的时候不太收敛,原话为:

Further, since it is difficult for the model to converge when timestep $t$ is large, we propose a timestepaware function to reduce the weight for large $t$.

Conclusions

总体说来这两个工作相较Emote Portrait Alive都是工程意义大于学术意义,作为开源工作demo效果还是要差一些的,例如背景的抖动:(放大看还是比较明显的)

原因或许还是在于Temporal Attention Layer上,本质上这个框架是SD的拓展而非真正的视频生成模型,因此时序关系的捕捉就尤为关键。目前介绍的几个工作虽然显式地进行了attention,但毕竟只有之前的几帧远远不够。接下来我们介绍使用长程依赖解决这一问题的Loopy。

References

- V-Express: Conditional Dropout for Progressive Training of Portrait Video Generation, -V-Express

Cong Wang, Kuan Tian, Jun Zhang, Yonghang Guan, Feng Luo, Fei Shen, Zhiwei Jiang, Qing Gu, Xiao Han, Wei Yang, 2024.06 | arXiv pdf Project homepage - EchoMimic: Lifelike Audio-Driven Portrait Animations through Editable Landmark Conditions, -EchoMimic

Zhiyuan Chen, Jiajiong Cao, Zhiquan Chen, Yuming Li, Chenguang Ma, 2024.07 | arXiv pdf Project homepage